推出 RxR:多语言指令跟随导航基准数据集

文 / Alexander Ku,软件工程师和 Peter Anderson,研究员,Google Research

机器学习 (ML) 的一项核心挑战是构建能够在复杂的实际环境中导航,并对口头或书面命令做出响应的代理 (Agents)。虽然如今的代理,包括机器人,通常可以在复杂的环境中导航,但它们还不能理解使用自然语言表达的导航目标,例如,“穿过右侧关闭的棕色双开门,然后站在椅子后面与桌子前面。”

为了促进该领域的发展,我们很高兴为 VLN 引入新数据集:Room-Across-Room(RxR)。如在 “ Room-Across-Room: Multilingual Vision-and-Language Navigation with Dense Spatiotemporal Grounding ” 中所述,RxR 是 VLN 的第一个多语言数据集,包含了 126,069 条人工标注的导航指令,它们使用三种不同类型的语言 - 英语、印地语和泰卢固语。

- Room-Across-Room

- Room-Across-Room:Multilingual Vision-and-Language Navigation with Dense Spatiotemporal Grounding

每条指令描述一条通过照片级模拟器的路径,模拟器中充满着各种室内环境,它们来自Matterport3D 数据集,其中包括居所、办公室和公共建筑的 3D 捕捉。为了追踪 VLN 的进展,我们还宣布了RxR 挑战赛,这是一项鼓励机器学习社区基于 RxR 指令训练和评估他们自己的指令跟随代理的竞赛。

- Matterport3D 数据集

- RxR 挑战赛

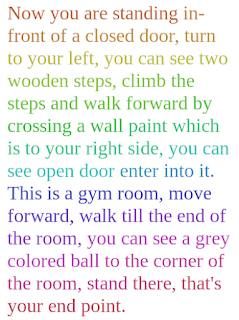

RxR 数据集中的英语、印地语和泰卢固语导航指令示例,每个导航指令均描述相同的路径

姿态轨迹

除了导航指令和路径外,RxR 还包括一个新的、更详细的多模态标注,称为姿态轨迹(Pose Traces)。受位置叙述数据集中捕捉的鼠标轨迹的启发,姿态轨迹通过丰富的 3D 设置在语言、视觉和运动之间提供紧密的知识基础(Dense Groundings)。

为了生成导航指令,我们要求向导(guide) 标注者在模拟器中沿一条路径移动,同时根据周围环境叙述路径。姿态轨迹是向导沿该路径看到的所有东西的记录,并且与导航指令中的文字在时间上对齐。然后,这些轨迹与跟随者(follower) 标注者的姿态轨迹配对,后者的任务是通过收听向导的音频来沿着预期路径行进,从而验证导航指令的质量。

姿态轨迹隐式捕获地标选择和视觉显著性概念,并实时表示如何解决导航指令生成任务(对于向导)和导航指令跟随任务(对于跟随者)。

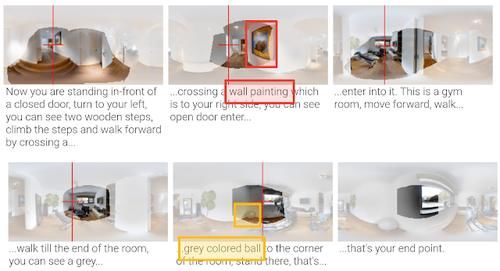

RxR 数据集中的英语导航指令示例。指令文本(右)中的单词经过颜色编码,与姿态轨迹(左)对齐,姿态轨迹显示了向导标注者在描述路径的环境中移动时的动作和视觉感知

相同的 RxR 示例,导航指令中的文字沿该路径与 360° 图像对齐。向导标注者观察到的场景部分会高亮显示;标注者忽略的场景部分会淡化。红色和黄色框高亮显示了文本指令与标注者视觉提示之间的一些紧密对齐。红色十字线指示标注者的下一个移动方向

规模

RxR 总共包含近 1000 万个单词,是现有数据集(如R2R和Touchdown/Retouchdown)的约 10 倍大。这很重要,因为与基于静态图像和文本数据的任务相比,需要通过运动或与环境的互动来学习的语言任务通常缺乏大规模训练数据。RxR 还解决了其他数据集(例如 R2R)中出现的已知路径构造偏差,此数据集中的所有路径都具有相似的长度,并且采用最短的路线到达目标。相比之下,RxR 中的路径平均长度更长,更不可预测,这使得它们更难以跟随,并鼓励在数据集中训练的模型更加强调语言在任务中的作用。RxR 的规模、范围和细节将扩展落地语言学习研究的领域,同时削弱英语等资源丰富的语言的主导地位。

上一篇:如何推进断代汉语语法史研究

下一篇:没有了